Sentinel Roblox Open Sourcing : notre approche de la détection préventive des risques

Utiliser l'IA pour aider à détecter rapidement les habitudes de conversation anormales

- Chaque jour, plus de 100 millions d'utilisateurs de tous âges vivent une expérience sûre et positive sur Roblox.

- Nous nous efforçons de rendre nos systèmes aussi sûrs que possible par défaut, en particulier pour nos utilisateurs les plus jeunes. Nous y parvenons grâce à nos politiques extrêmement conservatrices et nous tirons parti de l'IA pour filtrer les messages inappropriés dans le chat que nous détectons, y compris les informations personnellement identifiables (en dehors des Connexions de confiance). Nous modérons le contenu de manière proactive et ne permettons pas le partage d'images réelles dans le chat.

- Bien sûr, aucun système n'est parfait et l'un des plus grands défis de l'industrie est de détecter les dangers critiques comme les dangers potentiels pour les enfants. Une série de chats amicaux et de messages de soutien peut prendre une signification différente au cours d'une histoire conversationnelle plus longue, surtout lorsqu'elle se produit entre des utilisateurs de groupes d'âge différents. ;

- Nous avons développé Roblox Sentinel, un système d'IA basé sur l'apprentissage contrastif qui nous aide à détecter des signaux précoces de mise en danger potentielle des enfants, comme le grooming, ce qui nous permet d'enquêter encore plus tôt et, le cas échéant, de faire un signalement aux forces de l'ordre.

- Au cours du premier semestre 2025, Sentinel a aidé notre équipe à soumettre environ 1 200 rapports de tentatives potentielles d'exploitation d'enfants au National Center for Missing and Exploited Children (Centre national pour les enfants disparus et exploités). Cela comprend les tentatives de contourner nos mécanismes de filtrage et autres mesures de protection.

- Nous sommes ravis d'utiliser open source Sentinel, et nous recherchons activement l'engagement de la communauté, qui, nous l'espérons, contribuera à construire un Internet plus sûr.

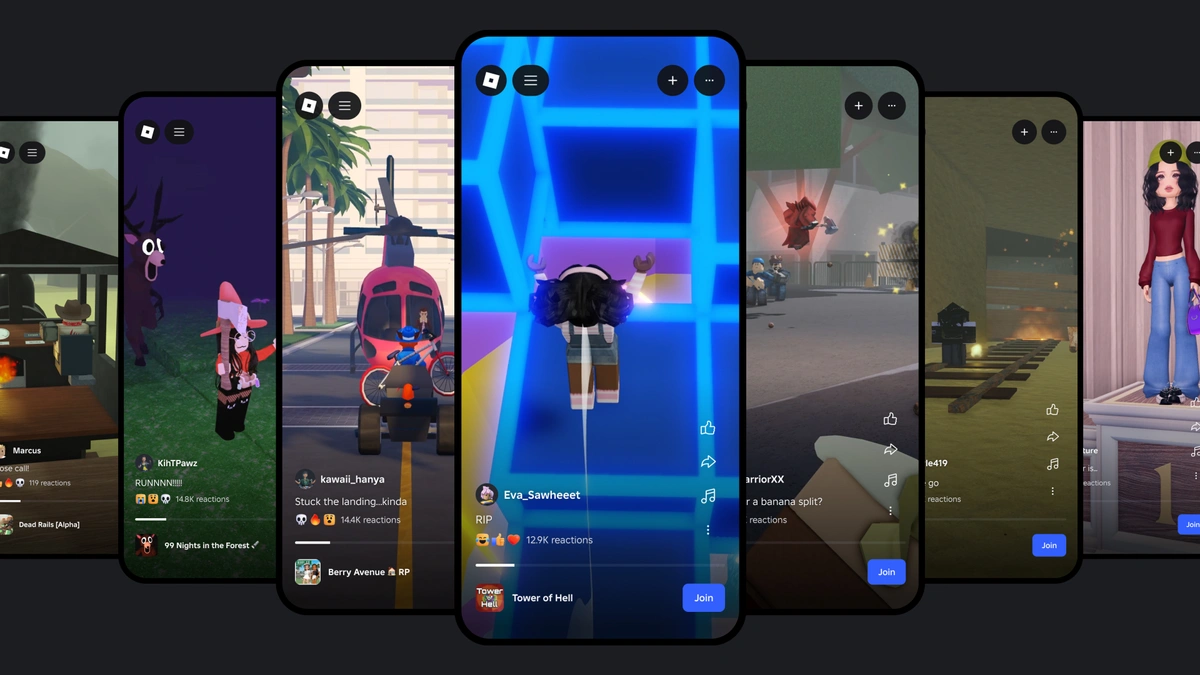

Passer du temps avec des amis et rivaliser avec d'autres joueurs est un élément central de Roblox, et la communication est au cœur de ces activités. En fait, chaque jour, plus de 111 millions d'utilisateurs viennent à Roblox, où la communauté envoie une moyenne de 6. milliards de messages de chat et génère 1,1 million d'heures de communications vocales dans des dizaines de langues. Cette communication reflète le monde réel : la grande majorité est des discussions quotidiennes, allant des conversations informelles à des discussions sur le gameplay, mais un petit nombre de mauvais acteurs cherchent à contourner nos systèmes et tentent éventuellement de causer des dommages.

Le mois dernier, nous avons partagé notre vision de la communication basée sur l'âge. Nous nous efforçons de rendre nos systèmes aussi sûrs que possible par défaut, en particulier pour nos utilisateurs les plus jeunes. Par exemple, nous n'autorisons pas le partage d'images ou de vidéos d'un utilisateur à l'autre par le biais du chat. Nos systèmes, bien qu'ils ne soient pas parfaits, s'améliorent continuellement et sont conçus pour bloquer proactivement les informations personnelles—comme les numéros de téléphone et les noms d'utilisateur—et le chat entre utilisateurs non vérifiés par l'âge est fortement filtré (et non autorisé pour les utilisateurs de moins de 13 ans). Roblox est l'une des plus grandes plateformes qui demandent une estimation de l'âge facial pour discuter plus librement avec les personnes que tu connais. Notre objectif est de devenir le leader mondial de la sécurité des jeux en ligne, et nous nous engageons à l'approvisionnement ouvert des technologies de sécurité clés.

Aujourd'hui, nous lançons notre dernier modèle open-source, Sentinel, un système d'IA conçu pour aider à détecter les interactions qui pourraient potentiellement entraîner un danger pour les enfants. Bien avant que quelque chose ne devienne explicite, Sentinel nous permet d'enquêter de façon subtile et de détecter rapidement des schémas et, le cas échéant, de les signaler aux forces de l'ordre.

Sentinel fonctionne sur Roblox depuis fin 2024 et est le dernier ajout à notre boîte à outils de sécurité open-source. Au cours de la première moitié de 2025, 35 % des cas que nous avons détectés sont dus à cette approche proactive, dans de nombreux cas, les attrapant avant qu'un signalement d'abus puisse être déposé. Lorsqu'il est combiné avec nos autres systèmes de modération, Sentinel élargit l'arsenal d'outils dont nous disposons pour détecter et agir sur ces violations potentiellement graves.

Comprendre le défi

La mise en danger des enfants est un défi dans toute l’industrie, rendant les nouvelles technologies et la collaboration ouverte d’une valeur incroyable. Le grooming en ligne—le développement systématique de la confiance et de la connexion émotionnelle dans le but ultime d'exploitation—est par nature un processus subtil et progressif. Ces interactions sont rares et commencent souvent comme une série de discussions amicales, de messages de soutien et d'intérêts partagés. Les messages qui paraissent initialement inoffensifs peuvent prendre un sens différent au cours d'une longue histoire de conversation. Les acteurs malveillants utilisent souvent un langage subtil, indirect ou codé — rendant délibérément les motifs difficiles à détecter, même pour les examinateurs humains. Par conséquent, nos systèmes de détection évoluent continuellement pour suivre le rythme des nouvelles manières que les mauvais acteurs tentent d'échapper à nos systèmes. En plus de cela, les données d'entraînement pour la prédation sexuelle sont rares, ce qui rend difficile l'entraînement des systèmes d'apprentissage automatique.

Impact proactif et perspectives opérationnelles

Sentinel est actuellement en production à l'échelle. Au cours du premier semestre 2025, ses capacités proactives ont aidé notre équipe à soumettre environ 1, 00 rapports au Centre national pour les enfants disparus et exploités. Bien que nous aurons toujours des marges d'amélioration, les capacités de détection précoce de Sentinel nous aident déjà à identifier et à enquêter sur des acteurs potentiellement malveillants plus tôt dans le processus, lorsque les messages sont encore subtils et avant qu'ils ne soient signalés par des rapports d'abus soumis par les utilisateurs.

Les experts humains sont essentiels pour enquêter et intervenir dans les cas que Sentinel détecte. Des analystes formés, généralement d'anciens agents de la CIA ou du FBI et d'autres experts, examinent les cas que Sentinel considère comme potentiellement violents. Les décisions prises par ces analystes créent une boucle de rétroaction qui nous permet d'affiner et de mettre à jour en permanence les exemples, les index et les ensembles de formation. Ce processus humain dans la boucle est essentiel pour aider Sentinel à s'adapter et à suivre le rythme des nouveaux modèles et méthodes en évolution des mauvais acteurs qui travaillent pour échapper à notre détection.

Sentinel est une partie importante du système de sécurité à plusieurs niveaux plus vaste de Roblox, qui combine des outils d'IA innovants et des milliers d'experts humains. À partir d'aujourd'hui, cela fait également partie de notre boîte à outils de sécurité open-source Roblox. Nous pensons que la promotion d'un monde numérique plus sûr est une responsabilité partagée. En mettant en open source des systèmes de sécurité comme Sentinel, et en partageant nos approches et en devenant membres fondateurs d'organisations telles que Robust Open Online Safety Tools (ROOST) et le Tech Coalition’s Lantern project, nous espérons contribuer à l'avancement collectif des pratiques de sécurité en ligne et des communautés en ligne qui s'appuient sur ces pratiques.

Trop de plateformes aujourd'hui manquent d'accès aux outils sophistiqués nécessaires pour identifier et prévenir les dommages en ligne, en particulier ceux visant les enfants. Chez ROOST, nous croyons que des protections de sécurité robustes devraient être accessibles à quiconque s'engage à protéger ses utilisateurs, et nous sommes très enthousiasmés que Roblox contribue à des outils plus largement disponibles dans le domaine de la confiance et de la sécurité.

Notre vision à long terme pour Sentinel dépasse la simple conversation. Les principes d’intégration et de mesure contrastée sont très adaptables. Nous explorons et développons activement des capacités pour appliquer ces techniques à un plus large éventail d'interactions avec les utilisateurs, en nous orientant vers une compréhension multimodale—à travers le texte, l'image, la vidéo, et plus encore. En analysant ces signaux ensemble, nous espérons travailler à une compréhension plus holistique et plus solide du comportement des utilisateurs afin de mieux identifier les risques potentiels pour la sécurité que les systèmes à modalité unique pourraient manquer.

Au cœur de la technologie : Comment Sentinel permet une détection préventive

Pour permettre à notre système de modération d'agir rapidement, avant que l'intention de nuire ne dépasse le stade de l'intention, Sentinel doit exécuter l'ensemble du pipeline d'analyse quasiment en temps réel—à une échelle massive, sur plus de 6 milliards de messages de chat chaque jour. Sentinel capture en continu le chat de texte en une minute. Les messages sont automatiquement analysés par ML, dans le seul but d'identifier les préjudices potentiels, tels que le grooming ou la mise en danger des enfants. En outre, nous regroupons ces informations au fil du temps, en identifiant les cas et les schémas préoccupants que les analystes humains peuvent évaluer et étudier.

Contrairement aux outils qui se basent sur des règles statiques et des exemples étiquetés, Sentinel utilise un apprentissage auto-supervisé pour apprendre à repérer—et à généraliser—les schémas de communication au fur et à mesure qu'ils se présentent. Cela permet à Sentinel d'identifier les menaces nouvelles et en évolution.

L'équipe y est parvenue en développant deux index. L'un est constitué de communications d'utilisateurs qui interagissent via des messages sûrs et bénins - l'indice positif. L'autre est composé de communications qui ont été retirées car nous avons déterminé qu'elles enfreignaient la politique de protection des enfants—l'indice négatif. Cette approche contrastive aide le système à généraliser et à identifier les menaces évolutives même si elles ne correspondent pas précisément aux modèles de communication détectés précédemment dans l'index. L'un des principaux avantages de Sentinel est qu'il ne nécessite pas un grand nombre d'exemplaires pour fonctionner. C'est particulièrement important à la lumière de la faible prévalence d'exemples négatifs. Notre système de production actuel fonctionne avec seulement 13 000 exemplaires dans l'index négatif, tout en identifiant avec succès le potentiel de préjudice.

L'index positif

Pour construire l'index positif, nous utilisons un échantillon conservé de l'historique des discussions de la part des utilisateurs sans historique de violations des normes communautaires de sécurité et cohérentes, engagement positif à long terme sur Roblox. En utilisant cet échantillon de l'historique des chats de Roblox, plutôt que des ensembles de données textuelles génériques, nous avons pu aider Sentinel à apprendre un nouvel argot et des modèles et styles de langage spécifiques à Roblox. Cela aide le système à faire des comparaisons plus précises, en réduisant les faux positifs et en lui permettant de mieux différencier la communication typique de Roblox de la communication violente.

L'index négatif

L'indice négatif est basé sur des conversations examinées par nos modérateurs humains, où nous avons trouvé des preuves claires de violations de la politique de mise en danger d'enfants (sur lesquelles nous avons déjà agi). Lorsque les interactions d'un utilisateur montrent une activité préoccupante et durable, nous étiquetons des extraits spécifiques de ces conversations comme des exemples de communication nuisible. Ces segments étiquetés sont transformés en vecteurs d'embedding et ajoutés à l'index négatif. Grâce à cette formation, Sentinel apprend à aller au-delà de la signalisation de certains mots ou phrases ; il apprend des modèles contextuels et des progressions que suivent les vraies conversations d'intention de nuire. En raison de cela, le système peut reconnaître des communications nuisibles que nos autres systèmes de modération par IA peuvent ne pas détecter, même lorsqu'elles semblent subtiles.

Par exemple, des messages simples tels que « Salut, comment ça va ? » correspondraient à l'indice positif car le langage est bienveillant. Un message comme « D'où viens-tu ? » correspondrait à l'indice négatif car il correspond à des motifs de conversations potentiellement manipulatrices. Le système compare les nouveaux messages avec ces index, et s'il voit un utilisateur demander « D'où viens-tu ? », il peut commencer à recueillir plus d'informations pour voir si la conversation continue dans une voie négative. Bien qu'un seul message ne suffise pas à signaler un examen humain, une tendance continue le serait.

Mesure contrastive

Cette approche de mesure contrastive est inspirée par SimCLR, un cadre d'apprentissage auto-supervisé qui utilise la mesure contrastive pour entraîner des modèles de représentation d'images sans données étiquetées. Nous avons adapté cette technique pour fonctionner avec des données textuelles et vocales, permettant à Sentinel de comprendre ce qu'un utilisateur dit et comment cela correspond ou diverge des modèles connus. Cela fonctionne en trois étapes : la notation des interactions, le suivi des modèles et la prise de décisions.

Mesurer les Interactions Individuelles : Chaque message est converti en un embedding, ou un vecteur qui capture les caractéristiques sémantiques et de communication de l'action. Sentinel compare cet encastrement aux indices positifs et négatifs. À l'aide de la similarité cosinus, le système mesure ensuite de quel index l'interaction est la plus proche.

Si l'interaction s'aligne davantage sur les modèles nuisibles de l'indice négatif, elle reçoit un indicateur de risque plus élevé. Les messages qui ne s'alignent pas de manière significative avec des modèles de communication sûrs ou nuisibles sont filtrés, afin que le système puisse se concentrer uniquement sur les interactions qui portent un signal potentiel. Cela peut aider à réduire les faux positifs et améliorer la précision de la mesure des interactions au fil du temps.

Suivi des modèles avec l'asymétrie, pas seulement les moyennes : Les acteurs malveillants cachent souvent leur intention en la mélangeant parmi du contenu inoffensif. Si nous prenions simplement la moyenne des mesures d'un utilisateur au fil du temps, les messages négatifs que nous voulons détecter pourraient être noyés dans le bruit. Au lieu de cela, Sentinel examine la distribution des mesures dans le temps et mesure l'asymétrie statistique — une manière de détecter s'il existe des messages rares et à haut risque qui tirent le profil de risque vers le haut.

Cela nous aide à détecter les premiers signes d'escalade vers des communications dangereuses, même si la plupart des interactions semblent bénignes. Lorsque nous analysons une asymétrie, nous la corrigeons également en fonction du volume. Les utilisateurs très actifs peuvent sembler plus à risque parce que leur communication montre un plus grand nombre absolu de correspondances. En mettant l'accent sur les asymétries statistiques plutôt que sur le volume global, nous pouvons éviter les faux positifs impliquant des utilisateurs de bavardages mais conformes. Grâce à cela, Sentinel n'est pas seulement évolutif, il est plus précis, capable de traiter de vastes flux de communication pour trouver les signaux rares mais critiques qui nous aident à détecter l'intention de nuire.

Passer du Signal à l'Action : Au fur et à mesure que davantage d'interactions sont mesurées, le système construit un profil de risque dynamique. Lorsque le schéma d'un utilisateur montre une forte correspondance avec des communications ayant une intention de nuire, ou un biais allant dans ce sens, Sentinel déclenche un signal pour un examen et une enquête plus approfondis.