Lancement de nouvelles langues pour notre modèle de sécurité vocale open source

-

Nous mettons à jour notre Système de classification de sécurité vocale open source en augmantant ses paramètres de 94 600 à 120 200 et en l'enrichissant de sept langues supplémentaires.

-

Depuis la première version du système de classification, nous avons amélioré sa précision pour atteindre un taux de rappel de 59,1 % sur les données de chat vocal en anglais, avec un taux de faux positifs de 1 %. Il s'agit d'une amélioration de 92 % par rapport au taux de rappel de 30,9 % de la version précédente.

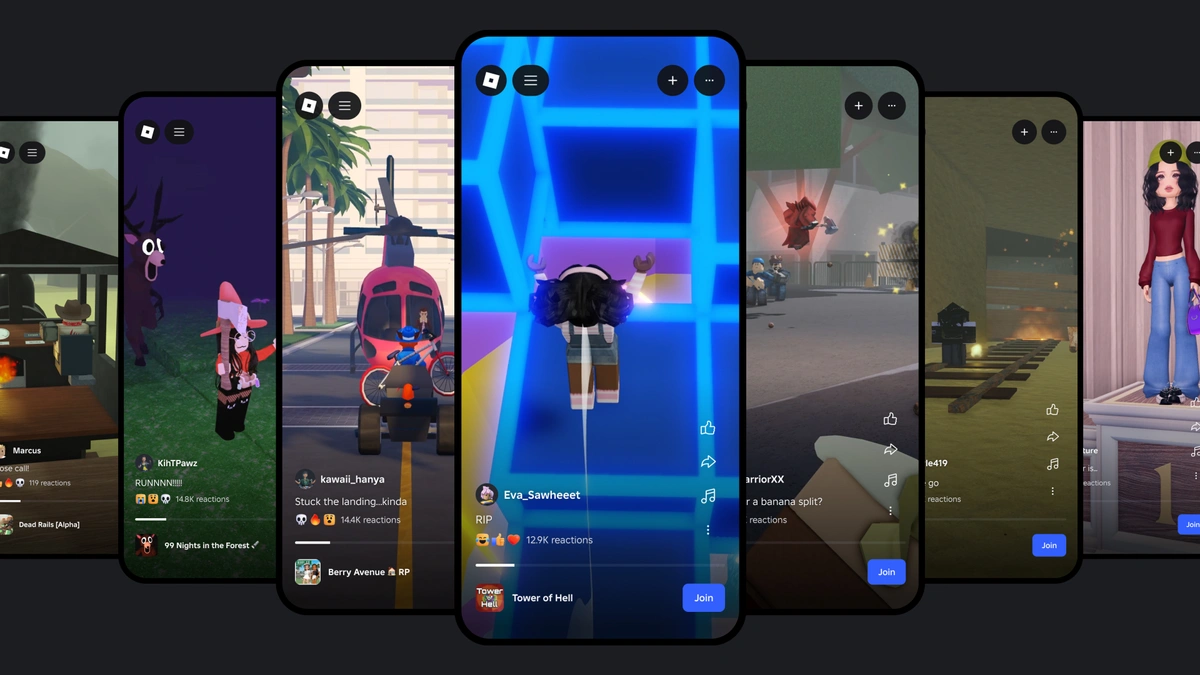

La promotion de la sécurité et du civilité a toujours été à la base de tout ce que nous faisons chez Roblox. Nous avons passé près de deux décennies à mettre en place des systèmes de sécurité solides, et nous les développons et les faisons évoluer en permanence à mesure que de nouvelles technologies deviennent disponibles. En 2024, nous avons mis en place plus de 40 améliorations en matière de sécurité, notamment un remaniement de nos contrôles parentaux, que nous actualisons de nouveau aujourd'hui. Nous avons également lancé l'un des premiers système de sécurité vocale de l'industrie open source,qui a été téléchargé plus de 23 000 fois. Aujourd'hui, nous publions une version mise à jour qui est encore plus précise et fonctionne dans davantage de langues.

Un grand nombre des systèmes de sécurité qui aident à protéger nos utilisateurs, y compris ce modèle de classification, sont alimentés par des modèles IA. Nous mettons certains d’entre eux en open source parce que nous savons que partager les avancées en matière de sécurité en IA profitent à l’ensemble de notre industrie. C'est aussi pourquoi nous avons récemment rejoint ROOST, une nouvelle organisation à but non lucratif dédiée à traiter des domaines importants de la sécurité numérique et qui promeut les outils de sécurité open-source en tant que partenaire fondateur.

Lors de la gestion du volume de contenu et des interactions qui se produisent sur notre plateforme tous les jours dans le monde, L'IA est un élément essentiel pour assurer la sécurité des utilisateurs. Nous sommes convaincus que les modèles que nous avons construits contribuent à répondre à nos besoins. Au quatrième trimestre 2024, par exemple, les utilisateurs de Roblox ont téléchargé 300 milliards de contenus. Seulement 0,01 % de ces milliards de vidéos, d'audios, de textes, de conversations vocales, d'avatars et d'expériences 3D ont été détectés comme violant nos politiques. Et la quasi-totalité de ces contenus en infraction avec la politique a été automatiquement présélectionnée et supprimée avant même que les utilisateurs ne les voient.

Nous avons mis à jour la version open source de notre système de classification de la sécurité des données vocales afin de le rendre plus précis et de nous aider à modérer le contenu dans un plus grand nombre de langues. Le nouveau modèle :

-

Détecte les violations dans sept langues supplémentaires (espagnol, allemand, français, portugais, italien, coréen et japonais) grâce à une formation sur les données multilingues.

-

A un taux de rappel global augmenté de 59,1 %, une amélioration de 92 % par rapport au rappel de 30,9 % dans la version précédente, avec de faibles taux de faux positifs.

-

Est optimisé pour servir à une échelle, servant jusqu'à 8 300 requêtes (dont la majorité ne contient pas de violations) par seconde au plus haut.

Depuis la sortie du premier modèle, nous avons constaté une réduction de plus de 50 % par heure de parole du taux de signalement d'abus chez les utilisateurs américains. Cela nous a également aidés à modérer des millions de minutes de chat vocal par jour avec plus de précision que des modérateurs humains. Nous ne cessons de faire progresser nos systèmes de sécurité et nous continuerons également à mettre à jour la version open source.

Système de classification de sécurité vocale efficace multilingue

Notre premier classificateur de sécurité vocale open source était basé sur un modèle WavLM base+, affiné avec des échantillons audio de chat vocal en anglais labellisés par une machine. Les résultats encourageants de cette architecture de bout en bout ont conduit à de nouvelles expériences avec une architecture personnalisée. Nous avons utilisé la méthode de distillation des connaissances pour optimiser la complexité et la précision du modèle, ce qui est intéressant pour le service d'inférence à grande échelle. Notre nouveau système de classification utilise ces éléments fondamentaux et étend et approfondit le travail sur l'utilisation des données et les améliorations de l'architecture.

En s'entraînant sur des données multilingues, notre modèle de classification unique peut fonctionner de manière transparente dans n'importe laquelle de nos huit langues principales. Et nos améliorations en matière de training signifient que le modèle est à la fois plus précis et 20 à 30 % plus rapide à exécuter dans un scénario d'inférence typique que la première version.

Le nouveau système de classification de sécurité vocale est toujours basé sur l'architecture WavLM mais la configuration des couches s'écarte de la version précédente et de celles des modèles préformés de WavLM. En particulier, nous avons ajouté une couche convolutionnelle supplémentaire pour réduire la résolution temporelle interne des couches de transformation. Au total, notre nouvelle architecture de modèle a 120 200 paramètres, une augmentation de 27 % par rapport à 94 600 dans la version précédente. Malgré cette augmentation, le nouveau modèle consomme 20 % à 30 % de temps de calcul en moins lorsqu'il est utilisé avec des segments d'entrée de 4 à 15 secondes. Ceci est possible parce que le modèle comprime le signal d'entrée en une représentation plus courte qu'avant.

Utiliser une variété de stratégies de labellisation

La formation supervisée d'un modèle de bout en bout nécessite des paires d'audio et de labels de classe. Nous avons apporté des améliorations significatives à notre pipeline de données qui ont permis d'assurer un flux constant de données labellisées. Le matériel de formation est basé sur un vaste ensemble de données labellisées par machine, comprenant plus de 100 000 heures de parole dans les langues prises en charge. Nous avons automatiquement transcrit le contenu du discours et l'avons soumis à notre système interne de classification de la toxicité, qui partage les catégories de politique et de toxicité souhaitées. La collecte de données échantillonne les contenus abusifs avec une probabilité plus élevée que les discours bénins afin de mieux saisir les cas limites et les violations de politique moins courantes.

Les labels basés sur les transcriptions de la parole et la classification basée sur le texte ne peuvent pas saisir toutes les nuances observées dans le contenu des conversations vocales. Nous avons donc utilisé des données labellisées par des humains pour affiner le modèle de la phase de formation précédente. Si la tâche de classification est la même, cette dernière étape de formation permet d'affiner les limites de décision et de mettre l'accent sur la réactivité aux expressions spécifiques au chat vocal. Il s'agit d'une forme d'apprentissage par le curriculum qui nous aide à tirer le meilleur parti des précieux exemples labellisés par l'homme.

L'un des défis de la formation sur un modèle de bout en bout est que les labels cibles peuvent devenir obsolètes si la politique de labellisation change au fil du temps. Ainsi, alors que nous affinons notre politique de voix acceptables, nous avons besoin d'un traitement spécial pour les données qui utilisent des normes de labellisation plus anciennes. Pour ce faire, nous avons utilisé une approche multitâche qui permet au modèle d'apprendre à partir d'ensembles de données qui ne correspondent pas à la politique actuelle de chat vocal. Cela implique de dédier une tête de classification distincte à l'ancienne politique, ce qui permet au modèle de base d'apprendre à partir de l'ancien ensemble de données sans affecter les labels ciblés ou la tête principale.

Un modèle calibrés pour un déploiement plus facile

L'utilisation du modèle de classification nécessite de décider du point de fonctionnement et de correspondre à la sensibilité du système de classification en fonction des exigences de la tâche. Pour faciliter le déploiement du modèle, nous avons calibré les sorties du modèle, optimisées pour la modération du chat vocal. Nous avons estimé les transformations linéaires par morceaux à partir d'un ensemble de données de test, en procédant séparément pour chaque tête de sortie et chaque langue prise en charge. Ces transformations ont été appliquées lors de la distillation du modèle, ce qui a permis de calibrer nativement le modèle final. Cela a éliminé le besoin de post-traitement pendant l'inférence.

Nous sommes ravis de partager ce nouveau modèle open source open source avec la communauté et nous sommes impatients de partager les futures mises à jour dès que nous les aurons.