La sécurité et la civilité à grande échelle sur Roblox

- Roblox a toujours été pensé pour protéger les plus jeunes, et nous nous adaptons actuellement à un nombre croissant d'utilisateurs plus âgés.

- En ce qui concerne les textes, les voix, les modèles 3D et le code, Roblox se situe dans une position unique avec les solutions d'IA multimodale.

- Quand nous le pouvons, nous contribuons également à l'amélioration de la sécurité dans l'ensemble du secteur grâce à l'open source, aux partenariats et à la collaboration avec les législateurs.

La sécurité et la civilité font partie des priorités de Roblox depuis sa création il y a presque vingt ans. Dès le premier jour, nous nous sommes engagés à intégrer des outils, des fonctions de sécurité et des capacités de modération au design de nos produits. Avant de lancer une nouvelle fonctionnalité, nous songeons à la façon dont nous pouvons protéger la communauté des éventuels abus. En pensant la sécurité et la civilité dès les premières étapes du processus de conception, avec notamment des tests préliminaires pour détecter les abus potentiels, nous pouvons mieux innover. Nous évaluons en permanence les dernières recherches et technologies en date afin de faire en sorte que nos politiques, nos outils et nos systèmes soient aussi précis et efficaces que possible.

En matière de sécurité, Roblox se situe dans une position unique. La plupart des plateformes étaient à la base conçues pour les adultes et doivent désormais ajouter des protections pour enfants et adolescents à leurs systèmes existants. Notre plateforme a au contraire été développée dès le départ pour être un espace sûr où les enfants pourraient créer et apprendre, et nous sommes en train de nous adapter à un public qui grandit rapidement. De plus, le volume de contenu que nous modérons a augmenté de façon exponentielle grâce aux fonctionnalités et outils d'IA générative qui permettent à toujours plus de personnes de créer et communiquer en toute simplicité sur Roblox. Ce ne sont pas des défis inattendus ; notre mission est de rassembler un milliard de personnes dans l'optimisme et la civilité. Nous avons toujours le regard tourné vers l'avenir afin de savoir quels sont les nouveaux outils et politiques de sécurité dont nous aurons besoin au fil de notre évolution.

Beaucoup de nos outils et fonctionnalités de sécurité fonctionnent grâce à des solutions d'IA innovantes encadrées par une équipe composée de milliers d'experts de la sécurité. Ce mélange stratégique d'humains expérimentés et de processus automatiques est indispensable pour le volume de contenu que nous devrons modérer 24 heures sur 24, 7 jours sur 7. Nous estimons également qu'il est important d'entretenir des partenariats avec des organisations spécialisées dans la sécurité en ligne et, lorsque nous le pouvons, nous soutenons les projets de loi qui peuvent selon nous améliorer l'ensemble du secteur.

L'IA pour la sécurité à grande échelle

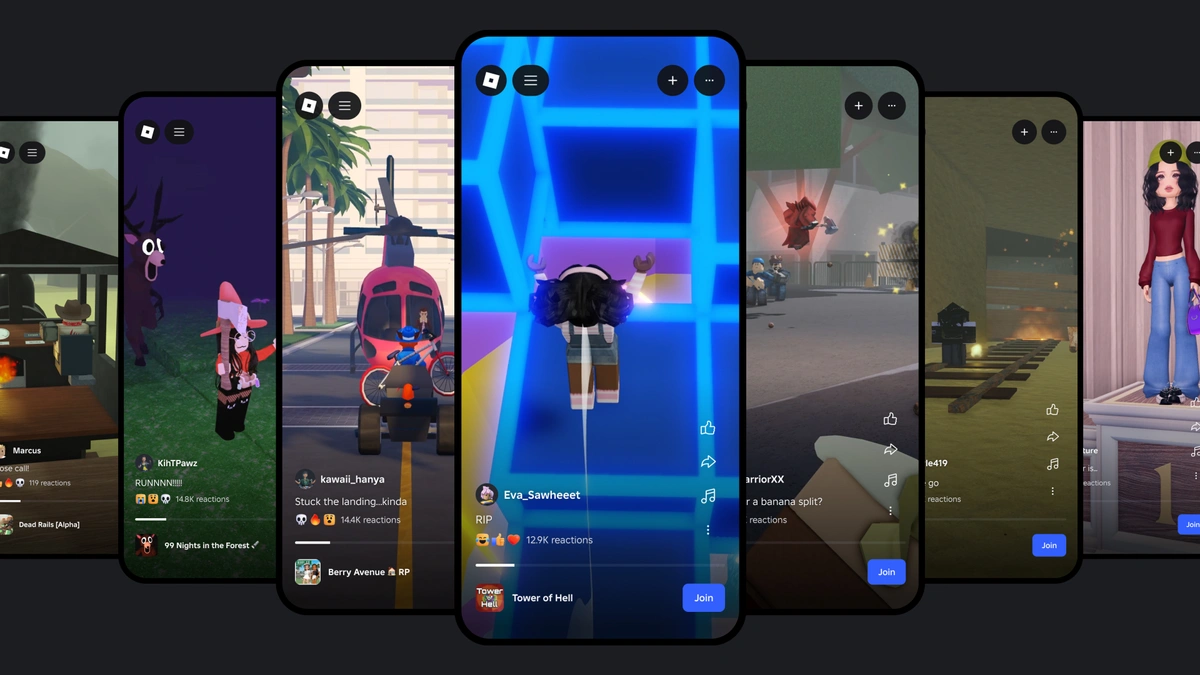

La taille de notre plateforme implique la nécessité de systèmes d'IA à la pointe de la technologie en matière de précision et de justesse, afin que nous puissions réagir rapidement à mesure que notre communauté s'agrandit, que les politiques et les exigences évoluent et que de nouveaux défis se présentent à nous. À l'heure actuelle, plus de 71 millions d'utilisateurs actifs quotidiens dans 190 pays communiquent et partagent du contenu sur Roblox. Chaque jour, les utilisateurs envoient des milliards de messages de chat à leurs amis sur Roblox. Notre Boutique du créateur propose des millions d'objets, et les créateurs ajoutent chaque jour de nouveaux objets et avatars au Marketplace. Ces chiffres vont continuer d'augmenter à mesure que nous développons notre plateforme et trouvons de nouvelles façons de permettre aux gens de créer et communiquer sur Roblox.

À l'heure où l'ensemble du secteur fait de grands progrès dans les domaines de l'apprentissage automatique, des grands modèles de langage (LLM) et de l'IA multimodale, nous investissons en masse dans l'utilisation de ces nouvelles solutions pour améliorer la sécurité sur Roblox. Les outils d'IA peuvent d'ores et déjà modérer le chat textuel, les communications vocales immersives, les images, les modèles 3D et les maillages. À l'heure actuelle, nous utilisons beaucoup de ces technologies afin de rendre la création sur Roblox plus rapide et plus simple pour notre communauté.

L'innovation avec les systèmes d'IA multimodale

De par sa nature même, notre plateforme associe textes, voix, images, modèles 3D et code. L'IA multimodale, pour laquelle l'entraînement se fait sur plusieurs types de données afin de produire des résultats plus précis et sophistiqués qu'avec un système monomodal, représente une opportunité unique pour Roblox. Les systèmes multimodaux sont capables de détecter les combinaisons de contenu (comme les images et les textes) potentiellement problématiques alors même que ces éléments individuels ne le sont pas. Imaginons par exemple un enfant qui utilise un avatar ressemblant à un cochon. Jusque-là, aucun problème. Imaginons ensuite que quelqu'un envoie un message dans le chat qui dise : « Ça te ressemble ! » Ce message pourrait constituer une infraction à nos politiques sur le harcèlement.

Un système entraîné uniquement sur des modèles 3D approuverait l'avatar, et un système entraîné uniquement sur les textes approuverait le message en ignorant le contexte de l'avatar. Seul un système entraîné à la fois sur les textes et les modèles 3D est à même de détecter et signaler rapidement le problème de cet exemple. Les modèles multimodaux n'en sont encore qu'à leurs débuts, mais nous envisageons un avenir relativement proche dans lequel nos systèmes réagiront aux signalements d'infraction en passant en revue l'ensemble de l'expérience. Ils pourront examiner le code, les graphismes, les avatars et les communications pour déterminer si une enquête ou des sanctions sont nécessaires.

Nous avons déjà réalisé de grands progrès en ce qui concerne l'utilisation des techniques multimodales, avec par exemple notre modèle qui détecte presque en temps réel les infractions aux politiques dans les communications vocales. Nous partagerons ces innovations lorsque nous aurons identifié une opportunité d'améliorer la sécurité et la civilité, non seulement sur Roblox, mais aussi dans l'ensemble du secteur. Nous partageons déjà notre premier modèle, un outil de classification de sécurité vocale, avec le reste du secteur.

Modérer le contenu à grande échelle

Chez Roblox, nous examinons la plupart des types de contenu afin d'identifier les infractions graves à nos politiques avant qu'elles ne soient visibles sur la plateforme. Pour accomplir cela sans latences perceptibles pour les personnes qui publient leur contenu, il faut un système qui soit rapide et efficace. Des solutions d'IA de pointe nous aident à prendre de meilleures décisions en temps réel pour empêcher le contenu problématique d'arriver sur Roblox ; et si jamais il y parvient, nous avons des systèmes en place pour l'identifier et le supprimer, comme nos systèmes de signalement très complets.

Nous avons constaté que la justesse de nos outils automatiques dépasse celles des modérateurs humains pour les tâches simples et répétitives. En automatisant ces processus simples, nous donnons plus de temps à nos modérateurs humains pour ce qu'ils font le mieux : les tâches complexes qui nécessitent d'enquêter en profondeur et de faire preuve d'esprit critique. Cependant, nous savons qu'en matière de sécurité, les outils automatiques ne pourront jamais remplacer complètement l'humain. Nos modérateurs humains nous apportent une aide inestimable en contrôlant et testant continuellement la qualité et la cohérence de nos modèles d'apprentissage, et en créant des ensembles de données étiquetés de haute qualité qui permettent à nos systèmes de rester à jour. Ils nous aident à identifier de nouvelles expressions d'argot et abréviations dans les 16 langues que nous prenons en charge, et signalent celles qui reviennent le plus souvent afin que le système puisse être entraîné à les reconnaître.

Parce que nous savons que même les meilleurs systèmes d'apprentissage automatique peuvent faire des erreurs, nous employons des modérateurs humains dans nos processus d'appel. Ils nous aident à prendre la bonne décision pour la personne qui a fait appel, et peuvent nous indiquer si un entraînement supplémentaire est nécessaire pour les situations où une erreur s'est produite. Ainsi, nos systèmes deviennent toujours plus précis et apprennent en quelque sorte de leurs erreurs. Néanmoins, des humains sont toujours impliqués dans les enquêtes critiques portant sur des situations à haut risque, comme l'extrémisme ou la mise en danger d'enfants. Pour ces situations, nous disposons d'une équipe interne spécialisée qui identifie et exclut de façon proactive les individus malintentionnés, et enquête sur les cas complexes dans les domaines les plus critiques. Cette équipe collabore également avec notre équipe de production en partageant les données issues de son travail afin que nous puissions améliorer en permanence la sécurité de notre plateforme et de nos produits.

Modérer la communication

Notre filtre de texte a été entraîné sur du langage spécifique à Roblox, avec notamment l'argot et les abréviations de la plateforme. Les 2,5 milliards de messages de chat envoyés chaque jour sur Roblox passent par ce filtre, capable de détecter les infractions à nos politiques. Le filtre détecte les infractions dans toutes les langues que nous prenons en charge, ce qui est particulièrement important depuis le lancement de la traduction du chat par IA.

Nous avons expliqué comment nous modérons les communications vocales en temps réel avec notre propre système de détection vocale. L'innovation, c'est le fait que le système d'IA puisse déterminer si l'audio présente une infraction aux politiques en quelques secondes seulement. Quand nous avons commencé à tester notre système de modération vocale, nous avons constaté que dans beaucoup de cas, les utilisateurs commettaient accidentellement des infractions car ils ne connaissaient pas nos règles. Nous avons donc développé un système de sécurité en temps réel qui prévient les utilisateurs lorsque leurs paroles ne respectent pas nos politiques.

Ces notifications se présentent sous la forme de légers avertissements, comme lorsque l'on demande poliment à quelqu'un de ne pas dire de grossièretés dans un parc où il y a de jeunes enfants. Lors des tests, ces interventions ont eu un impact positif en rappelant aux utilisateurs qu'ils devaient faire preuve de respect et en les renvoyant aux politiques pour qu'ils puissent en savoir plus. Comparés aux données d'engagement, les résultats de ces tests sont prometteurs et indiquent que ces outils pourraient empêcher les personnes malintentionnées d'accéder à la plateforme tout en encourageant les utilisateurs de bonne foi à améliorer leur comportement sur Roblox. Depuis le déploiement du système de sécurité en temps réel pour tous les utilisateurs anglophones en janvier, nous avons constaté une réduction de 53 % du nombre de signalements en lien avec les communications vocales par utilisateur actif quotidien.

Modérer la création

Pour les éléments visuels, dont les avatars et les accessoires, nous utilisons la vision par ordinateur. Notre technique consiste à prendre des photos de l'objet sous plusieurs angles. Le système examine ensuite ces photos pour décider de la marche à suivre. S'il n'y a aucun problème, l'objet est approuvé. S'il y a une infraction claire à nos politiques, l'objet est bloqué et nous indiquons au créateur quel est selon nous le problème. Si le système n'est pas sûr, l'objet est envoyé à un modérateur humain qui l'examine et prend la décision finale.

Il existe des versions de ce processus pour les avatars, les accessoires, le code et les modèles 3D complets. Pour les modèles complets, nous allons plus loin et évaluons le code et l'ensemble des éléments du modèle. Si nous examinons une voiture, nous séparons ses composants (volant, sièges, pneus et le code sous-jacent) afin de déterminer si l'un d'entre eux est problématique. Si un avatar ressemble à un chiot, nous devons déterminer si les oreilles, les yeux ou la langue posent problème.

Nous devons également réaliser l'opération inverse. Il est possible que les composants individuels ne posent aucun problème, mais que l'ensemble constitue une infraction à nos politiques. Par exemple, une moustache, une veste kaki et un brassard rouge ne posent aucun problème séparément. Cependant, si on les met ensemble sur un avatar avec un symbole ressemblant à une croix sur le brassard et un bras dressé comme dans un salut nazi, le problème devient clair.

C'est là que nos modèles se distinguent des autres systèmes de vision par ordinateur. Ces derniers sont généralement entraînés sur des objets du monde réel. Ils peuvent reconnaître une voiture ou un chien, mais pas leurs composants. Nos modèles ont quant à eux été entraînés et optimisés pour évaluer les objets en prenant en compte tous leurs composants, jusqu'aux plus petits.

Collaborer avec nos partenaires

Nous utilisons tous les outils à notre disposition pour protéger les utilisateurs de Roblox, mais nous tenons également à partager ce que nous apprenons. Nous partageons déjà notre premier modèle, un outil de classification de sécurité vocale, pour aider d'autres plateformes à améliorer leurs systèmes de sécurité. Nous collaborons également avec des groupes tiers pour partager des connaissances et des recommandations à mesure que le secteur évolue. Nous créons et entretenons des relations avec un grand nombre d'associations, dont des groupes de parents, des organisations de santé mentale, des agences gouvernementales et des agences de forces de l'ordre. Cela nous permet de mieux comprendre les préoccupations des parents, des législateurs et d'autres groupes en matière de sécurité en ligne. En retour, nous partageons nos connaissances et la technologie que nous utilisons pour faire en sorte que notre plateforme soit sûre et civile.

La sécurité des utilisateurs les plus jeunes et les plus vulnérables de notre plateforme a toujours été une priorité pour nous. Nous avons mis en place des initiatives comme le programme des signalements approuvés afin de pouvoir protéger toujours plus de personnes sur notre plateforme. Nous collaborons avec les législateurs sur des projets de loi et autres initiatives en lien avec la sécurité des enfants. Nous avons par exemple été la première entreprise, et l'une des seules, à soutenir le projet de loi « California Age-Appropriate Design Code Act », car nous estimons qu'il sera bénéfique pour les plus jeunes. Quand nous pensons que quelque chose sera positif pour la jeunesse, nous voulons en faire profiter tout le monde. Récemment, nous avons signé une lettre de soutien à la proposition « California Bill SB 933 », qui a pour but de mettre à jour les lois de l'État afin d'interdire explicitement la pédopornographie générée par IA.

Travailler pour un avenir plus sûr

C'est une tâche qui n'est jamais terminée. Nous sommes déjà en train de travailler sur la prochaine génération d'outils et fonctionnalités de sécurité, tout en permettant à tout le monde de créer plus facilement sur Roblox. Tout en grandissant et en proposant de nouvelles façons de créer et de partager, nous continuerons de développer de nouvelles solutions de pointe pour garantir la sécurité et la civilité sur Roblox, et ailleurs.