Sicurezza e civiltà scalabili su Roblox

- Roblox è stato progettato fin dall'inizio per proteggere gli utenti più giovani; ora ci stiamo adeguando a un pubblico in crescita di utenti più adulti.

- Avendo a disposizione testo, voce, immagini, modelli 3D e codici, Roblox si trova nella posizione ideale per avere successo tramite le soluzioni di intelligenza artificiale multimodale.

- Miglioriamo la sicurezza nel settore laddove possibile, tramite l'open source, le collaborazioni con i partner o il sostegno alla legislazione.

La sicurezza e la civiltà sono due aspetti fondamentali per Roblox sin dalla sua creazione, quasi vent'anni fa. Fin dal primo giorno, ci siamo impegnati a integrare nella progettazione dei nostri prodotti funzioni e strumenti di sicurezza, e capacità di moderazione. Prima di introdurre qualsiasi nuova funzionalità, pensiamo già a come tenere la community al sicuro da potenziali danni. Questo processo di progettazione delle funzionalità in materia di sicurezza e civiltà fin dal principio, compresi i test iniziali per verificare come una nuova funzionalità potrebbe essere utilizzata in modo improprio, ci aiuta nell'innovazione. Esaminiamo continuamente le ultime ricerche e tecnologie disponibili per mantenere le nostre politiche, i nostri strumenti e i nostri sistemi il più accurati ed efficienti possibile.

In termini di sicurezza, Roblox si trova in una posizione privilegiata. La maggior parte delle piattaforme è nata come luogo per adulti e ora sta operando retroattivamente per integrare le protezioni per adolescenti e bambini. La nostra piattaforma, invece, è stata sviluppata fin dall'inizio come uno spazio sicuro e protettivo per la creazione e l'apprendimento da parte dei bambini, e ora ci stiamo adeguando a un pubblico adulto in rapida crescita. Inoltre, il volume di contenuti che moderiamo è cresciuto in modo esponenziale, grazie a nuove ed entusiasmanti funzionalità di intelligenza artificiale generativa e a strumenti che consentono a un numero ancora maggiore di persone di creare e comunicare facilmente su Roblox. Non si tratta di sfide inaspettate: il nostro obiettivo è quello di connettere un miliardo di persone all'insegna dell'ottimismo e della civiltà. Guardiamo sempre al futuro per capire di quali nuove politiche e strumenti di sicurezza avremo bisogno man mano che cresciamo e ci adattiamo.

Molti dei nostri strumenti e delle nostre funzioni di sicurezza si basano su soluzioni innovative di intelligenza artificiale che operano insieme a un team di migliaia di esperti che si dedicano alla sicurezza. Questa combinazione strategica di persone esperte e di automazione intelligente è indispensabile per ridimensionare il volume di contenuti che moderiamo 24 ore al giorno, 7 giorni su 7. Riteniamo inoltre che sia importante coltivare le partnership con le organizzazioni che si occupano di sicurezza online e, quando è il caso, sosteniamo le leggi che crediamo possano migliorare il settore nel suo complesso.

L'intelligenza artificiale per una scalabilità sicura

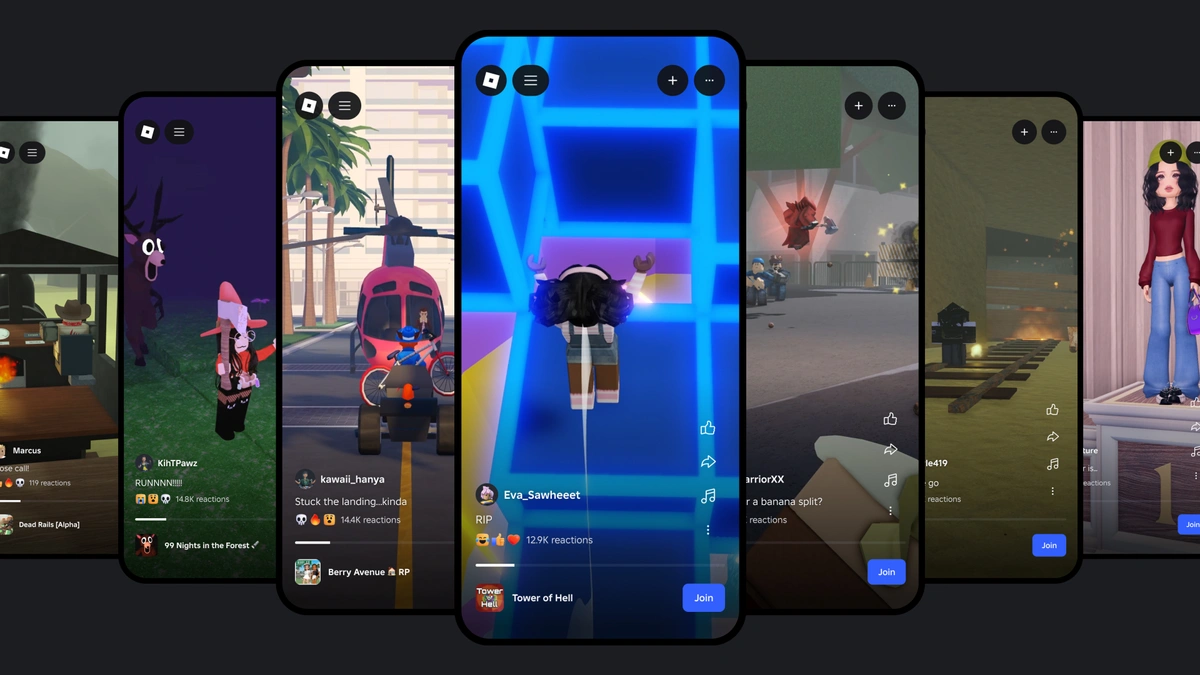

La vastità della nostra piattaforma richiede sistemi di intelligenza artificiale che soddisfino o superino i parametri di riferimento del settore per quanto riguarda l'accuratezza e l'efficienza, consentendoci di intervenire rapidamente alla crescita della community, all'evoluzione delle politiche e dei requisiti e all'insorgere di nuove sfide. Oggi, più di 71 milioni di utenti attivi giornalmente in 190 Paesi comunicano e condividono contenuti su Roblox. Ogni giorno, le persone inviano miliardi di messaggi in chat ai loro amici su Roblox. Nel Negozio creatori ci sono milioni di oggetti in vendita, e ogni giorno i creatori aggiungono nuovi avatar e oggetti al Marketplace. Tutto questo non potrà che aumentare man mano che continueremo a crescere e a offrire agli utenti nuovi modi per creare e comunicare su Roblox.

Mentre il settore in generale fa passi da gigante nel campo dell'apprendimento automatico (ML), dei modelli linguistici di grandi dimensioni (LLM) e dell'intelligenza artificiale multimodale, noi investiamo nelle modalità per utilizzare queste nuove soluzioni per rendere Roblox ancora più sicuro. Le soluzioni di intelligenza artificiale ci aiutano già a moderare la chat di testo, la comunicazione vocale immersiva, le immagini, e i modelli e le mesh 3D. Attualmente stiamo utilizzando molte di queste tecnologie per rendere la creazione su Roblox più veloce e più facile per la nostra community.

Innovare con i sistemi di intelligenza artificiale multimodale

Per sua natura, la nostra piattaforma combina testo, voce, immagini, modelli 3D e codici. L'intelligenza artificiale multimodale, in cui i sistemi vengono addestrati su più tipi di dati insieme per produrre risultati più accurati e avanzati rispetto a un sistema unimodale, costituisce un'opportunità straordinaria per Roblox. I sistemi multimodali sono in grado di rilevare combinazioni di tipi di contenuti (come immagini e testo) che potrebbero essere problematiche rispetto a elementi singoli. Per capire come potrebbe funzionare, supponiamo che un bambino utilizzi un avatar con l'immagine di un maiale: non c'è niente di male, vero? Ora immaginiamo che un utente invii un messaggio di chat con scritto "Ti assomiglia davvero tanto! ". Questo messaggio potrebbe violare le nostre politiche sul bullismo.

Un modello addestrato solo sui modelli 3D approverebbe l'avatar. E un modello addestrato solo sul testo approverebbe il testo, ignorando il contesto dell'avatar. In questo caso, soltanto un modello addestrato sul testo e sui modelli 3D insieme sarebbe in grado di individuare e segnalare rapidamente il problema. Siamo ancora in una fase iniziale di questi modelli multimodali, ma immaginiamo un mondo, in un futuro non troppo lontano, in cui il nostro sistema risponderà a una segnalazione di abuso esaminando un'intera esperienza. Il sistema potrebbe elaborare il codice, le immagini, gli avatar e le comunicazioni al suo interno come input e determinare se sono necessarie ulteriori indagini o conseguenze.

Abbiamo già compiuto progressi notevoli utilizzando tecniche multimodali, come il nostro modello che rileva le violazioni delle politiche nelle comunicazioni vocali quasi in tempo reale. È nostra intenzione condividere progressi di questo tipo non appena rileviamo la possibilità di migliorare la sicurezza e la civiltà non solo su Roblox, ma in tutto il settore. Infatti, intendiamo condividere con il settore il nostro primo modello open source: un classificatore di sicurezza vocale.

Moderazione dei contenuti su scala

In Roblox, esaminiamo la maggior parte dei tipi di contenuti per individuare eventuali violazioni critiche delle nostre politiche prima che appaiano sulla piattaforma. Fare ciò senza causare ritardi notevoli agli utenti che pubblicano i loro contenuti richiede velocità e precisione. Le soluzioni innovative di intelligenza artificiale ci aiutano a prendere decisioni migliori in tempo reale per evitare che i contenuti problematici vengano pubblicati su Roblox e, se dovessero riuscire ad arrivare sulla piattaforma, disponiamo di sistemi in grado di identificarli e rimuoverli, tra cui i nostri efficienti sistemi di segnalazione degli utenti.

Abbiamo riscontrato che l'accuratezza dei nostri strumenti di moderazione automatizzati supera quella dei moderatori umani quando si tratta di svolgere operazioni semplici e reiterabili. Automatizzando questi casi più semplici, consentiamo ai moderatori umani di dedicare la maggior parte del loro tempo a ciò che sanno fare meglio: le attività più complesse che richiedono capacità di pensiero critico e indagini più approfondite. Quando si tratta di sicurezza, tuttavia, siamo consapevoli che l'automazione non può sostituire completamente la verifica umana. I nostri moderatori umani forniscono un contributo prezioso nell'aiutarci a supervisionare e testare continuamente i modelli di apprendimento automatico per verificarne la qualità e la coerenza, e per creare insiemi di dati etichettati di alta qualità per tenere aggiornati i nostri sistemi. Ci aiutano a individuare nuovi slang e abbreviazioni in tutte le 16 lingue supportate e a segnalare i casi in cui ricorrono più frequentemente, in modo che il sistema possa essere addestrato a riconoscerli.

Siamo consapevoli del fatto che anche i sistemi di apprendimento automatico di alta qualità possono commettere errori, ed è per questo motivo che nel nostro processo di ricorso sono presenti dei moderatori umani. I moderatori ci aiutano a risolvere il problema per l'utente che ha presentato il ricorso, e possono inoltre segnalare la necessità di ulteriore addestramento sui tipi di casi nei quali sono stati commessi errori. In questo modo, il sistema diventa sempre più preciso nel tempo, imparando sostanzialmente dai propri errori.La cosa più importante è che i moderatori umani sono sempre coinvolti in tutte le indagini critiche che riguardano casi ad alto rischio, come l'estremismo o il maltrattamento di minori. Per questi casi, abbiamo un team interno ad hoc che si occupa di identificare e rimuovere in modo proattivo gli utenti malintenzionati e di indagare su casi difficili nelle aree più critiche. Questo team collabora anche con il team di prodotto, condividendo spunti derivanti dal lavoro che svolgono per migliorare continuamente la sicurezza della nostra piattaforma e dei nostri prodotti.

Moderazione della comunicazione

Il nostro filtro di testo è stato addestrato sul linguaggio specifico di Roblox, compresi lo slang e le abbreviazioni. I 2,5 miliardi di messaggi di chat inviati ogni giorno su Roblox vengono esaminati da questo filtro, che è in grado di rilevare se il linguaggio viola le norme. Questo filtro rileva le violazioni in tutte le lingue supportate, il che è particolarmente importante ora che abbiamo rilasciato la traduzione della chat con IA in tempo reale.

In passato abbiamo condiviso il modo in cui moderiamo le comunicazioni vocali in tempo reale attraverso un sistema di rilevamento vocale personalizzato interno. L'innovazione in questo caso consiste nella possibilità di etichettare un audio dal vivo come violazione delle norme o meno da parte del sistema di intelligenza artificiale, tutto nel giro di pochi secondi. Quando abbiamo iniziato a testare il nostro sistema di moderazione vocale, abbiamo scoperto che, in molti casi, le persone violavano involontariamente le nostre politiche perché non conoscevano le regole. Abbiamo sviluppato un sistema di sicurezza in tempo reale per segnalare alle persone quando il loro linguaggio viola una nostra politica.

Queste segnalazioni costituiscono un avvertimento iniziale e discreto, simile a un invito cortese a moderare il linguaggio in un parco pubblico quando ci sono bambini piccoli in giro. In fase di test, questi interventi si sono rivelati efficaci nel ricordare alle persone di essere rispettose e nell'indirizzarle alla consultazione delle nostre politiche per avere maggiori informazioni. Se confrontati con i dati relativi all'engagement, i risultati dei nostri test sono positivi e indicano che questi strumenti sono in grado di impedire ai malintenzionati di accedere alla piattaforma e di spingere gli utenti realmente coinvolti a migliorare il loro comportamento su Roblox. Da quando, a gennaio, abbiamo introdotto la sicurezza in tempo reale per tutti gli utenti che parlano inglese, abbiamo registrato una riduzione del 53% delle segnalazioni di abuso relative alla comunicazione vocale, per ogni utente attivo giornalmente.

Moderazione della creazione

Nel caso delle risorse visive, compresi gli avatar e gli accessori per gli avatar, utilizziamo la computer vision (CV). Una tecnica consiste nello scattare foto all'oggetto da più angolazioni. Successivamente, il sistema esamina le foto per determinare come procedere. Se non c'è nulla che non va, l'oggetto viene approvato. Se invece c'è qualcosa che viola in modo evidente una norma, l'oggetto viene bloccato e il creatore viene informato di ciò che riteniamo non vada bene. Se il sistema non è sicuro, l'oggetto viene inviato a un moderatore umano che lo esaminerà più approfonditamente e prenderà la decisione finale.

Eseguiamo una versione dello stesso processo per avatar, accessori, codici e modelli 3D completi. Nel caso dei modelli completi, facciamo un ulteriore passo e valutiamo tutto il codice e gli altri elementi che li compongono. Ad esempio, se stiamo valutando un'auto, la scomponiamo in tutti i suoi componenti (volante, sedili, pneumatici e il codice sottostante) per determinare se ci sia qualcosa di problematico. Se c'è un avatar che ha l'immagine di un cucciolo, dobbiamo valutare se le orecchie, il naso e la lingua sono problematici.

Ma dobbiamo essere in grado di valutare un oggetto anche nella direzione opposta. Cosa succede se i singoli componenti non hanno alcun problema, ma il loro insieme viola le nostre politiche? Ad esempio, dei baffi, una giacca color cachi e una fascia rossa al braccio non sono problematici di per sé. Ma se li immaginiamo insieme nell'avatar di un utente, con un simbolo simile a una croce sulla fascia e un braccio alzato che imita il saluto nazista, il problema diventa evidente.

È in questo che i nostri modelli interni si differenziano dai modelli di CV standardizzati. Questi ultimi vengono generalmente addestrati su oggetti del mondo reale. Sono in grado di riconoscere un'auto o un cane, ma non le parti che li compongono. I nostri modelli sono stati addestrati e ottimizzati per valutare gli oggetti anche nei loro componenti più piccoli.

Collaborazioni

Utilizziamo tutti gli strumenti a nostra disposizione per garantire la sicurezza di tutti gli utenti di Roblox, ma siamo altrettanto convinti di dover condividere ciò che impariamo anche al di fuori. Infatti, intendiamo condividere con il settore il nostro primo modello open source, un classificatore di sicurezza vocale, al fine di aiutare gli altri a migliorare i propri sistemi di sicurezza vocale. Collaboriamo anche con gruppi di terze parti per condividere le conoscenze e le pratiche migliori man mano che il settore si evolve. Instauriamo e manteniamo rapporti stretti con un'ampia gamma di organizzazioni, tra cui gruppi di difesa dei genitori, organizzazioni per la salute mentale, agenzie governative e forze dell'ordine. Ciò ci permette di conoscere le preoccupazioni dei genitori, dei responsabili delle politiche e di altri gruppi in materia di sicurezza online. In cambio, abbiamo la possibilità di condividere le nostre conoscenze e la tecnologia che utilizziamo per garantire la sicurezza e la civiltà sulla piattaforma.

Abbiamo una comprovata esperienza nel mettere al primo posto la sicurezza degli utenti più giovani e vulnerabili sulla nostra piattaforma. Abbiamo creato dei programmi, come il nostro programma di segnalazioni fidate, che ci aiuta ad ampliare il raggio d'azione mentre operiamo per proteggere gli utenti sulla piattaforma. Collaboriamo con i responsabili delle politiche in merito a iniziative fondamentali per la sicurezza dei bambini, alla legislazione e ad altre azioni. Per esempio, siamo stati la prima e una delle poche aziende a sostenere il California Age-Appropriate Design Code Act, perché crediamo che sia nell'interesse dei giovani. Quando riteniamo che qualcosa possa aiutare i giovani, facciamo in modo di diffonderlo a tutti. Di recente, abbiamo firmato una lettera a sostegno del California Bill SB 933, che aggiorna le leggi statali per vietare espressamente i contenuti di abuso sessuale su minori generati con IA.

Verso un futuro più sicuro

Questo lavoro non finisce mai. Stiamo già progettando la prossima generazione di strumenti e funzionalità per la sicurezza, pur rendendo la creazione su Roblox più facile per tutti. Man mano che cresciamo e offriamo nuovi modi per creare e condividere, continueremo a sviluppare nuove soluzioni all'avanguardia per garantire a tutti sicurezza e civiltà su Roblox, e non solo.