Lancio di altre lingue per il nostro modello di sicurezza vocale Open-Source

-

’stiamo aggiornando il nostro classificatore di sicurezza vocale open-source aumentando i suoi parametri da 94, 00 a 120,200 e ampliandolo a sette lingue aggiuntive.

-

Fin dalla prima versione del classificatore,’abbiamo aumentato la precisione ad un richiamo di 59. % sui dati di chat vocale in lingua inglese ad un 1% falsi positivi. Si tratta di un miglioramento del 92% rispetto al precedente release’s 30,9%.

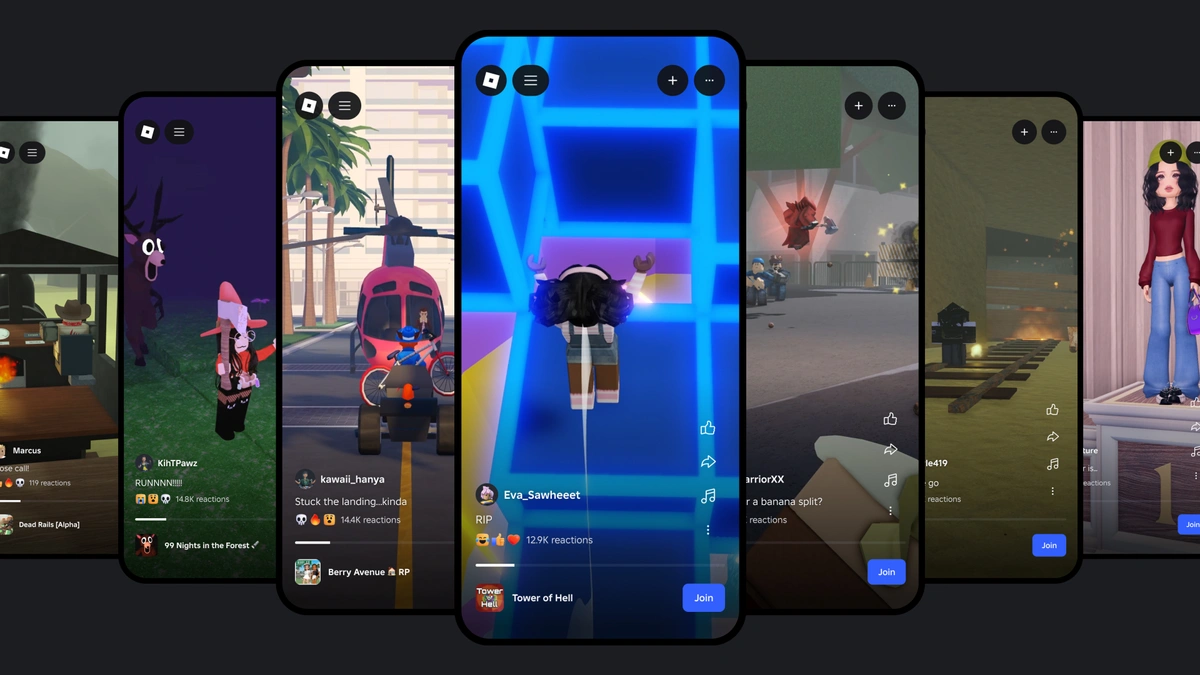

Promuovere la sicurezza e la civiltà è sempre stato fondamentale per tutto ciò che facciamo a Roblox. Noi’abbiamo trascorso quasi vent'anni a costruire sistemi di sicurezza forti, e’siamo in continua crescita ed evoluzione, man mano che la nuova tecnologia diventa disponibile. Nel 2024, abbiamo spedito più di 40 miglioramenti di sicurezza, tra cui un rinnovo al nostro Parental Controls, che noi’re aggiornando ancora oggi. Abbiamo anche lanciato uno dei classificatori di sicurezza vocale’s first ever open-source , che è stato scaricato più di 23.000 volte. Oggi noi’stiamo rilasciando una versione aggiornata , che è ancora più accurata e funziona in più lingue.

Molti dei sistemi di sicurezza che aiutano a proteggere i nostri utenti, compreso questo classificatore, sono alimentati da modelli AI. Abbiamo open-source alcuni di questi perché sappiamo che la condivisione di AI progressi di sicurezza avvantaggia l'intero settore. Che’è anche il motivo per cui di recente abbiamo aderito a ROOST—una nuova associazione senza scopo di lucro dedicata ad affrontare importanti settori della sicurezza digitale promuovendo gli strumenti di sicurezza open-source—come partner fondatore.

Quando si gestisce il volume di contenuti e interazioni che si verificano sulla nostra piattaforma ogni giorno in tutto il mondo, L'IA è un elemento essenziale per mantenere gli utenti al sicuro. Noi’siamo fiduciosi che i modelli che’ve costruito stanno aiutando a supportare le nostre esigenze. Nel quarto trimestre del 2024, ad esempio, gli utenti Roblox hanno caricato 300 miliardi di pezzi. Solo lo 0,01% di quei miliardi di video, audio, testi, chat vocali, avatar e esperienze 3D sono stati individuati come violazioni delle nostre politiche. E quasi tutti i contenuti di policy-violating sono stati automaticamente prescreed e rimossi prima che gli utenti lo vedevano.

’ve ha aggiornato la versione open-source del nostro classificatore di sicurezza vocale per renderlo più preciso e per aiutarci a moderare i contenuti in più lingue. Il nuovo modello:

-

Rileva le violazioni in altre sette lingue—spagnolo, tedesco, francese, portoghese, italiano, coreano e giapponese—grazie alla formazione sui dati multilingue.

-

Ha un aumento del tasso di richiamo complessivo del 59,1%, un miglioramento del 92% rispetto al 30,9% richiamato nel rilascio precedente, con bassi tassi falsi positivi.

-

È ottimizzato per servire su scala, servendo fino a 8.300 richieste (la maggior parte delle quali non contengono violazioni) al secondo al massimo.

Dal rilascio del primo modello,’ve ha visto una riduzione dei tassi di rapporto di abuso tra gli Stati Uniti utenti di più del 50% per ora di discorso. ’s ci ha anche aiutato moderato milioni di minuti di chat vocale al giorno in modo più preciso rispetto ai moderatori umani. Non smettiamo mai di far avanzare i nostri sistemi di sicurezza e’continueremo ad aggiornare anche la versione open-source.

Classificatore di sicurezza vocale multilingue efficiente

Il nostro primo classificatore di sicurezza vocale open-source si basava su un modello WavLM base+, perfezionato con campioni audio di chat vocale in lingua inglese etichettata a macchina. I risultati incoraggianti di questa architettura end-to-end hanno portato a ulteriori esperimenti con un'architettura personalizzata. Abbiamo utilizzato la distillazione della conoscenza per ottimizzare il modello’s complessità e precisione, che è attraente per il servizio di inferenza su larga scala. Il nostro nuovo classificatore utilizza questi elementi fondamentali e amplia e amplia il lavoro nell'utilizzo dei dati e nei raffinamenti dell'architettura.

Con la formazione su dati multilingui, il nostro modello di classificatore unico può funzionare senza problemi in qualsiasi delle nostre otto migliori lingue supportate. E i miglioramenti della nostra formazione fanno sì che il modello sia più preciso e più veloce del 20-30% da eseguire in uno scenario di inferenza tipico rispetto alla prima versione.

Il nuovo classificatore di sicurezza vocale è ancora basato sull'architettura WavLM, ma la configurazione dello strato si discosta dal rilascio precedente e da quelli dei modelli preformati WavLM. In particolare, abbiamo aggiunto un ulteriore strato convolutionale per ridurre la risoluzione interna dei livelli di trasformatore. Complessivamente, il nostro nuovo modello di architettura ha 120.200 parametri, un aumento del 27% rispetto a 94.600 nella versione precedente. Nonostante questo aumento, il nuovo modello consuma dal 20% al 30% in meno di tempo di calcolo se utilizzato con 4-15-secondi segmenti di ingresso. Questo è possibile perché il modello comprime il segnale in ingresso in una rappresentazione più breve rispetto a prima.

Utilizzando una varietà di strategie di etichettatura

La formazione supervisionata di un modello end-to-end richiede coppie curate di etichette audio e classe. Abbiamo apportato miglioramenti significativi alla nostra pipeline di dati che garantiva un flusso costante di dati etichettati. La fondazione del materiale di formazione è un grande set di dati etichettati a macchina di più di 100.000 ore di discorso che comprende le lingue supportate. Abbiamo automaticamente trascritto il discorso e lo abbiamo gestito attraverso il nostro classificatore di tossicità in-house basato sul testo, che condivide le politiche e le categorie di tossicità desiderate. La raccolta di dati campioni contenuti abusivi con una probabilità più alta del discorso benigno per meglio catturare i casi di bordo e meno comuni violazioni delle politiche.

Etichette basate su trascrizioni vocali e classificazione basata sul testo possono’t catturare completamente le sfumature osservate nel contenuto di chat vocale. Così abbiamo utilizzato i dati con l'etichetta umana per affinare il modello dalla fase di formazione precedente. Mentre l'attività di classificazione è la stessa, l'ultima fase di formazione aiuta a affinare i confini di decisione e sottolineare la reattività alle espressioni specifiche di chat vocale. Questa è una forma di apprendimento del curriculum che ci aiuta a trarre il massimo beneficio dai preziosi esempi etichettati dall'uomo.

Una sfida per la formazione di modelli end-to-end è che le etichette target possono diventare obsolete se la politica di etichettatura cambia nel tempo. Per perfezionare la nostra politica vocale accettabile, abbiamo bisogno di un trattamento speciale per i dati che utilizzano vecchi standard di etichettatura. Per questo, abbiamo utilizzato un approccio multitask che permette al modello di imparare dai set di dati che don’t corrisponde alla politica di chat vocale corrente. Si tratta di dedicare un capo di classificazione separato per la vecchia politica, permettendo al tronco modello di imparare dal vecchio set di dati senza influenzare le etichette mirate o la testa primaria.

Un modello calibrato per una distribuzione più facile

L'utilizzo del modello di classificazione richiede di decidere il punto operativo e di corrispondere alla sensibilità del classificatore in base ai requisiti del compito. Per facilitare la distribuzione del modello più semplice, abbiamo calibrato gli output del modello, sintonizzati per la moderazione della chat vocale. Abbiamo stimato le trasformazioni lineari pezzi-ewise da un set di dati in held-out, facendolo separatamente per ogni testa di uscita e il linguaggio supportato. Queste trasformazioni sono state applicate durante la distillazione del modello, che ha permesso di calibrare nativamente il modello finale. Ciò ha eliminato la necessità di post-trattamento durante l'inferenza.

Siamo entusiasti di condividere questo nuovo modello open-source con la community e non vediamo l'ora di condividere gli aggiornamenti futuri come li abbiamo.